Rynek mieszkań na progu zmian

W II kw. 2024 r. stawki za metr pójdą w górę, ale powiększy się też pole do negocjacji, gdyż urośnie liczba ofert — twierdzą eksperci.

Prologis odkłada akwizycje i zakasuje rękawy

Zakupy nowych obiektów w Polsce planowane w 2023 r. przez globalnego inwestora nie doszły do skutku. W tym roku plany firmy są ostrożniejsze – zakładają samodzielną budowę kilku obiektów z umowami przednajmu.

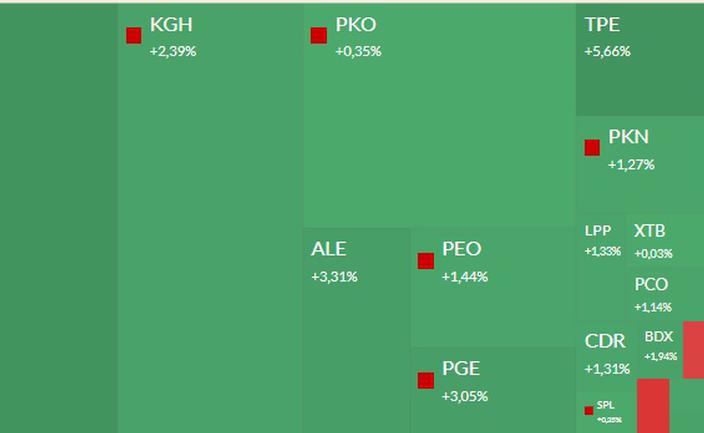

Mapa GPW: Dino, KGHM, Tauron, banki i Azoty w centrum uwagi

Gwiazdą początku sesji jest właściciel sieci sklepów, a powodem są wyniki największego rywala.

CVC, właściciel Żabki, ustalił cenę w IPO na 14 EUR

Na 14 EUR, a więc w środku widełek cenowych, ustalono cenę akcji CVC Capital Partners w pierwotnej ofercie publicznej.

Zwyżka kursu Jeronimo ciągnie w górę Dino

Notowania Jeronimo Martins, właściciela sieci Biedronka, zareagowały zwyżką o 7 proc. na wyniki za I kwartał. Pomaga to notowaniom Dino Polska.

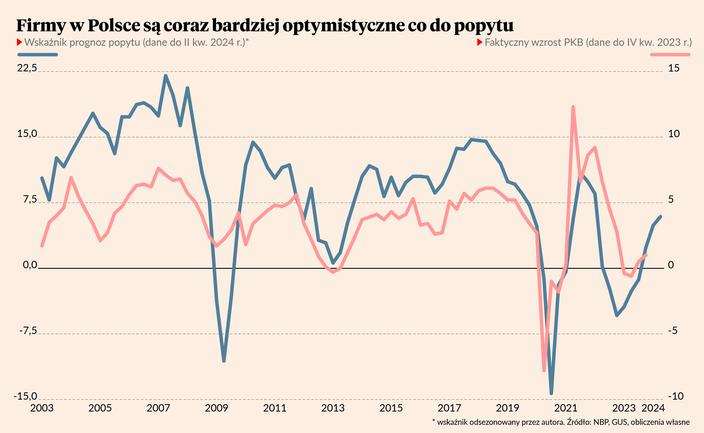

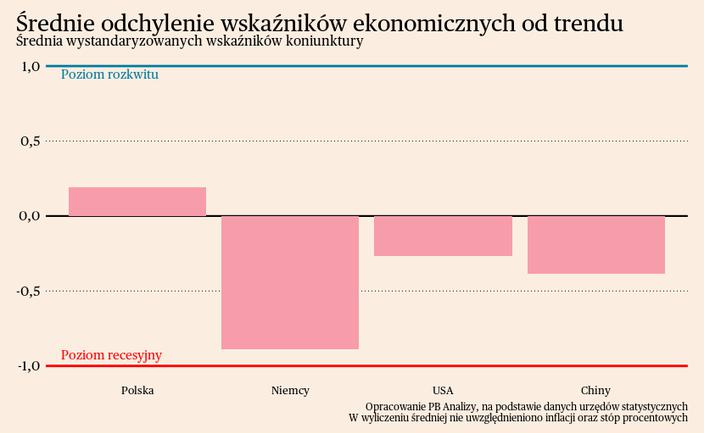

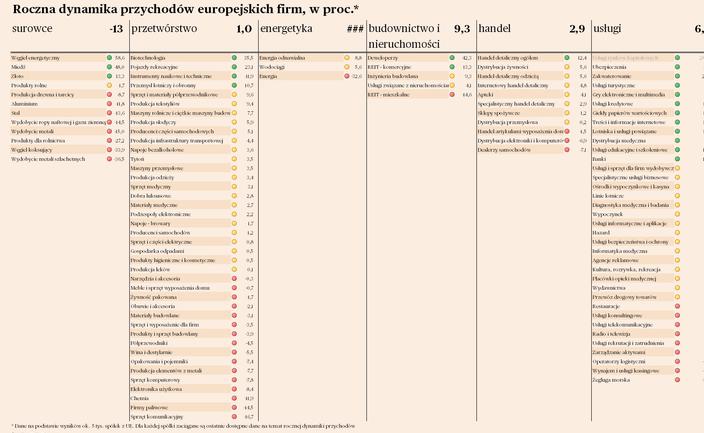

W badaniach firm widać coraz więcej optymizmu

Rośnie optymizm wśród przedsiębiorstw. Pokazują to najnowsze kwartalne badania ankietowe NBP. Biznes przewiduje wzrost popytu na swoje produkty, najbardziej w sektorach nastawionych na sprzedaż krajową.

CPK: przygotowania do budowy kolei dużych prędkości

Spółka spodziewa się w maju decyzji dotyczącej unijnego dofinansowania na budowę tunelu w Łodzi. W przyszłym roku, jeśli uda się zdobyć unijne fundusze, może także ogłosić przetarg na budowę odcinka Łódź—Warszawa.

Otomoto Pay kusi autami z wyższej półki

Dzięki współpracy z cyfrowym bankiem platforma pośrednicząca w udzielaniu finansowania na zakup samochodu dotrze do klientów, którzy chcą mieć auto lepsze, młodsze i na raty.

Comp ma apetyt na kaucyjny tort

W 2025 r. zacznie w Polsce działać system kaucyjny obejmujący dużą część opakowań m.in. z plastiku. Dla producenta kas fiskalnych to nie lada gratka.

Producenci napojów powołają operatora systemu kaucyjnego

Firmy wystąpiły o zgodę do UOKiK. Nawet jednak jeśli szybko ją dostaną, trudno będzie im zbudować system w terminie, czyli do stycznia 2025 r.

Miliony z FENG dla firm na ekoinnowacje

Premia ekologiczna pomoże przedsiębiorcom częściowo spłacić kredyty zaciągnięte na realizację projektów przyjaznych środowisku.

Zysk netto Grupy Orlen za 2023 r. wyniósł ponad 20,7 mld zł

Zysk netto Grupy Orlen za 2023 r. wyniósł ponad 20,7 mld zł - podał w czwartek koncern. Prezes Orlenu Ireneusz Fąfara w liście do akcjonariuszy zwrócił uwagę, że skonsolidowany wynik Grupy Orlen za 2023 r. obciążyły odpisy wartości aktywów na 17,2 mld zł.

Izba Cywilna SN podjęła uchwałę ws. kredytów frankowych

Do pięciu kluczowych problemów dotyczących spraw kredytów frankowych odnosi się podjęta w czwartek późnym wieczorem uchwała Izby Cywilnej Sądu Najwyższego.

Michał Sobolewski wiceprezesem banku PKO BP

Rada nadzorcza PKO BP powołała Michała Sobolewskiego na stanowisko wiceprezesa banku - podał bank w czwartkowym komunikacie giełdowym.

KGHM pod nowymi skrzydłami

Zarząd miedziowej grupy opowiedział o zmianach kadrowych, aktualizacji strategii oraz nowym podejściu do małego atomu.

Gaz-System ma umowę na wielki statek

Gaz-System, narodowy operator systemu przesyłowego gazu, podpisał w czwartek umowę dotyczącą czarteru FSRU, czyli pływającego terminala LNG, który będzie pracował w Zatoce Gdańskiej. Kontrakt został zawarty z firmą White Eagle Energy.

Ubezpieczyciele nadrabiają zaległości

W ciągu ostatnich dwóch lat ok. 80 proc. ubezpieczycieli zwiększyło nakłady finansowe na cyfryzację, a liczba ich partnerów technologicznych wzrosła w tym czasie aż o 60 proc.

Cognor: w tym roku nie będzie gorzej niż w zeszłym

Wyniki spółki napędzają zamówienia z motoryzacji i ukraińskiej zbrojeniówki oraz wsparcie państwa dla firm energochłonnych. W 2024 r. grupa liczy na wzrost popytu z budowlanki

Bloober Team myśli o akwizycjach, ale sam też jest na celowniku

Giełdowy producent gier wideo, który w ubiegłym roku przejął jedną firmę, nadal rozgląda się za akwizycjami. Przyznaje, że sam również jest obiektem zainteresowania inwestorów.

Mo-Bruk uczy się życia bez bomb

Niższa liczba przetargów z wysokomarżowego, ale nieprzewidywalnego segmentu miała negatywny wpływ na wyniki spółki, która próbuje się od niego uniezależnić.

Radosław Nielek: w NASK prowadzono gospodarkę rabunkową

Nowy szef NASK widzi instytut w roli regionalnego lidera w obszarze cyberbezpieczeństwa. Najpierw jednak trzeba skończyć audyt (zajmuje się nim skarbówka) i generalne porządki, m.in. z... szachistami i podejrzanymi fakturami.

Shoper wrzucił piąty bieg i nie zamierza zwalniać

Giełdowa spółka wypracowała wysoką dynamikę wzrostu wyników w I kw., a kwiecień wskazuje na kontynuację pozytywnego trendu. Pracuje nad nowymi produktami, rozmawia o akwizycjach z kilkoma podmiotami.

Złoty Bankier

Oto najlepsze banki w 2024 r.

Po raz 25. rozdajemy nagrody Złoty Bankier. Najcenniejsze trofeum — Złoty Bank — zdobył Santander. To już trzecia statuetka w jego kolekcji. Na drugim miejscu uplasował się ubiegłoroczny lider — Millennium, a na podium znalazł się też PKO BP.

Dzisiaj konkurujemy z sektorem e-commerce

Michał Gajewski, prezes Santander Bank Polska, który ma najlepszy serwis na rynku, mówi, że jeśli chodzi o UX klienta, to chce mierzyć się już nie tylko z bankami, ale też z firmami z rynku e-commerce. Tu poziom NPS jest dwa razy wyższy niż na rynku bankowym.

Oto najlepsze bankowe konta osobiste

W tym roku wybraliśmy nie tylko najlepsze rachunki na rynku. Zrobiliśmy pełny przegląd kont osobistych. Najlepszy okazał się PKO BP.

Który bank ma najlepsze hipoteki

O miejscu w rankingu zdecydował rządowy program Bezpieczny kredyt 2 proc. Podium opanowały państwowe banki: PKO BP, Pekao i Alior.

Kredyty gotówkowe dla VeloBanku

Złoty Bankier trafia do beniaminka zestawienia najlepszych produktów na rynku — wszedł na rynek z najwyższą dynamiką sprzedaży. Drugi jest Santander — prawdziwy kombinat kredytów. Trzeci Citi Handlowy — od zawsze sprawny w gotówkach.

Analizy PB

PREMIUMRaporty

Bądź dobrze poinformowany – czytaj codzienne analizy kluczowych danych wraz z prognozami.

Platforma danych

Korzystaj z bazy zawierającej 5000 danych z polskiej i światowej gospodarki. Analizuj i twórz personalizowane wykresy.

Newsletter

Wiedz więcej - kluczowe zjawiska gospodarcze tłumaczy Ignacy Morawski, główny ekonomista PB.

Rynki

Podatki potrafią wywołać spadki

Do końca kwietnia inwestorzy muszą rozliczyć się z podatku za wyjątkowo dobry rok na giełdzie. Amerykańskie przykłady pokazują, że taka sytuacja potrafi wywołać zniżki indeksów.

BofA: rynek akcji w USA będzie rósł dopóki realna stopa nie wystraszy inwestorów

Stratedzy Bank of America uważają, że spółki o największej kapitalizacji nadal będą napędzać wzrost amerykańskiego rynku akcji dopóki wzrost realnej stopy procentowej nie wywoła obaw recesji, informuje Bloomberg.

Nowy stary prezes Bogdanki

Zbigniew Stopa po ośmiu latach wróci na stanowisko prezesa Lubelskiego Węgla Bogdanka.

Wzrost awersji do ryzyka uderzył w ETF na bitcoina

Fundusze ETF na bitcoina spot zanotowały jeden z największych odpływów pieniędzy od rozpoczęcia działalności w styczniu po tym jak dane makro w USA wywołały awersję do ryzyka na rynkach, informuje Bloomberg.

Rekordowe zakupy chińskich akcji

W piątek zagraniczni inwestorzy wydali rekordową kwotę ponad 3 mld USD na zakup akcji chińskich spółek notowanych na giełdach na kontynencie.

Firma

Miliony z FENG dla firm na ekoinnowacje

Premia ekologiczna pomoże przedsiębiorcom częściowo spłacić kredyty zaciągnięte na realizację projektów przyjaznych środowisku.

Warto walczyć o swoje pieniądze

Mali przedsiębiorcy unikają windykacji, obawiając się braku jej skuteczności i popsucia relacji z kontrahentami. Niesłusznie.

Polscy konsumenci coraz chętniej sięgają po marki własne

Prawie jedna trzecia Polaków chce w najbliższych miesiącach kupować więcej produktów marek własnych. Przekonują ich do tego głównie konkurencyjne ceny.

Polisy dla menedżerów coraz trudniej dostępne

Fala roszczeń płynąca do członków władz spółek przekłada się na wzrost stawek polis D&O. Tymczasem zainteresowanie takim zabezpieczeniem jest coraz większe.

Czego najbardziej boją się mikro i małe firmy

Przedsiębiorców niepokoją przede wszystkim rosnące koszty działalności i nierzetelni kontrahenci. Z kolei najmniej obawiają się niestabilności politycznej kraju.

Czy można wyczyścić dane z BIK

Wielu kredytobiorców chętnie usunęłoby niewygodne informacje na temat spłaty swoich zobowiązań. Czy jest to możliwe?

Finansowa zachęta do zatrudniania silversów

Nowelizacja ustawy o promocji zatrudnienia zakłada wsparcie firm, które podpiszą umowy o pracę z emerytami. Na czym będzie polegała ta pomoc?

Mniejszy popyt na usługi faktorów

Spadła wartość faktur finansowanych w ramach faktoringu. Podmioty go oferujące liczą, że sytuacja poprawi się przed końcem roku.

Po godzinach

Rzuć wszystko, jedź w góry!

Niektórzy już dziś zaczynają nawet dziewięciodniową majówkę, więc zapraszam na podcast o jednym ze sposobów spędzania wolnego czasu: chodzeniu po górach. Posłuchajcie, jak to jest prowadzić schronisko, z czego i jak inwestuje w obiekty PTTK i jakie nowe projekty planuje, ale przede wszystkim, co mówią pasjonaci, którzy bez gór po prostu nie mogą żyć. A jeśli przy okazji złapiecie bakcyla, tym lepiej!

PB Poleca

Startupy pozytywnego wpływu na środowisko

KSeF – nowy obowiązek szansą na technologiczny rozwój

Bankowość inwestycyjna pierwszego wyboru

Zwycięzcy Tech Minds zmieniają oblicze edukacji

Pierwsza umowa Amazon na zakup energii wiatrowej w Polsce

Etyka w biznesie: Moralność przedsiębiorców w obliczu zatorów płatniczych

Fundusze Europejskie dla firm

Przeterminowane należności zagrożeniem stabilności finansowej

Multimedia

![Rzuć wszystko, jedź w góry! [PODCAST]](https://images.pb.pl/filtered/52a7ece1-5003-4ace-9170-67dcd843525b/544afc2e-2f4a-48b8-97f4-bd28b5e21798_704x433.jpg)

Rzuć wszystko, jedź w góry! [PODCAST]

Niektórzy już dziś zaczynają nawet dziewięciodniową majówkę, więc zapraszam na podcast o jednym ze sposobów spędzania wolnego czasu: chodzeniu po górach. Posłuchajcie, jak to jest prowadzić schronisko, z czego i jak inwestuje w obiekty PTTK i jakie nowe projekty planuje, ale przede wszystkim, co mówią pasjonaci, którzy bez gór po prostu nie mogą żyć. A jeśli przy okazji złapiecie bakcyla, tym lepiej!

Fundusze Europejskie - skorzystamy wszyscy

Zrównoważony transport z unijnym wsparciem

Zrównoważona mobilność czyli miejska strategia racjonalnego podróżowania staje się coraz bardziej popularna wśród polskich samorządów. Zwłaszcza, że to obszar, który może liczyć na solidne dofinansowanie ze środków unijnych.

Zdobądź grant na obieg zamknięty

Przedsiębiorcy chcący wdrażać modele biznesowe, które wpisują się w koncepcję GOZ, będą mogli ubiegać się o dofinansowanie na ten cel. W puli jest 10 mln zł.

Mydlarnia Cztery Szpaki lansuje się poza Polską

Firmy łatwiej sięgną po dotacje

Najciekawsze dotacje dostępne we wrześniu

Gazele Biznesu 2023

![Zastój na rynku pracy i dużo zmian dla emerytów [WIDEO]](https://images.pb.pl/filtered/ab6ef305-b662-4a18-be68-2c7fdf8c2e64/20a09ad1-3bd0-5215-9dc1-ffb0f742f223_704x433.jpg)